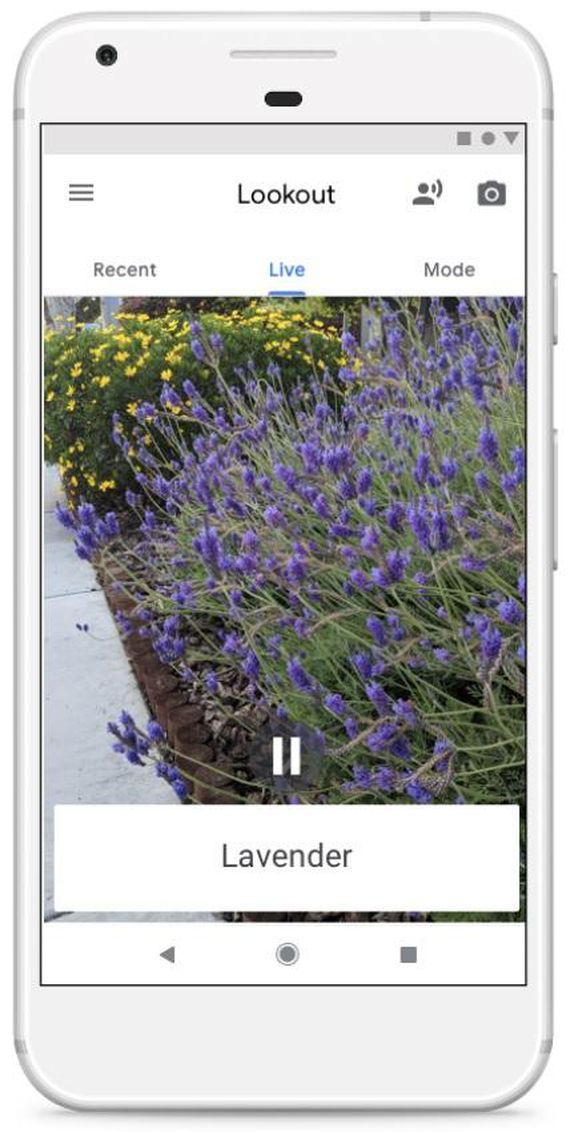

提供:Google

Googleは米国時間5月8日、周囲にある物体やテキスト、人についてユーザーに音声で情報を伝える「Android」版アプリ「Lookout」を開発していることを明らかにした。

Lookout: an app to help blind and visually impaired people learn about their surroundings(英文)

https://www.blog.google/topics/accessibility/lookout-app-help-blind-and-visually-impaired-people-learn-about-their-surroundings/

Lookoutを使用する際には、このアプリをインストールしたデバイスをシャツのポケットに入れたり、ネックストラップで首にかけたりして、カメラが身体の外側に向くように装着する。

Lookoutは、ユーザーのその時点での行動に基づき4つのモードで動作する。これらのモードにはそれぞれ「Home(自宅)」「Work & Play(仕事や遊び)」「Scan(スキャン)」「Experimental(実験)」という名がついている。モードを選択すると、アプリは自宅のソファの場所や職場のエレベータの位置など、周囲で検知した物体についてユーザーに音声で伝える。

アプリのScan機能は料理本に掲載されたレシピなどのテキストを読み上げることも可能なほか、Experimentalモードでは開発中の各種機能を試すことができる。

このアプリはインターネット接続がなくても使用可能で、機械学習を利用してユーザーが音声で伝えてほしいと思っている情報を学習する。

Lookoutアプリは2018年内に米国向け「Google Play」ストアで提供開始される予定だ。

関連スレ

【IT】グーグル モールス信号で文字入力 読み上げ技術を公開

http://2chb.net/r/bizplus/1525909620/

2018年05月10日 11時22分

CNET Japan

https://japan.cnet.com/article/35118917/